Monty Hall et l’entrainement de votre modèle

Guillaume Nicoulaud

Senior Consultant

Monty Hall et l’entrainement de votre modèle

Jouons à un jeu, voulez-vous ? Le maître du jeu dispose devant vous 3 boîtes parfaitement opaques dans l’une desquelles il a lui-même placé une pièce d’or de grande valeur [1] (i.e. les deux autres sont désespérément vides). Votre objectif, évidemment, est trouver la boîte qui contient la pièce. Jusque-là, le jeu que je vous propose ressemble à une variante du bonneteau mais la suite et tout à fait différente.

Une fois votre choix initial fait, le maître du jeu va ouvrir devant vous une boîte qu’il sait être vide et qui n’est ni la boîte que vous avez sélectionné ni, évidemment, la boîte qui contient la précieuse pièce d’or. À ce moment-là, vous avez deux possibilités : confirmer votre premier choix ou, au contraire, changer d’avis (ci-après switcher) et sélectionner l’autre boîte qui reste fermée.

Plutôt qu’un long discours, jouons [2] !

Cliquez sur Jouer pour démarrer le jeu.

À partir de là, notre humanité se divise en deux groupes distincts :

-

Il y a celles et ceux d’entre vous qui ont déjà étudié le problème (ou « paradoxe ») de Monty Hall et savent (ce mot n’est pas en italique pour rien) que lorsque le maître du jeu leur propose de changer d’avis, ils ont toutes les meilleures raisons du monde de le faire ;

-

Les autres, c’est-à-dire celles et ceux qui ne connaissent pas « le truc » et qui, par voie de conséquence, ont très probablement pris la bien mauvaise décision qui consiste à conserver leur choix initial.

Si vous faites parti du premier groupe, celui des initiés (si j’ose dire), la section suivante ne vous apprendra sans doute pas grande chose ; dans le cas contraire, la suite devrait vous convaincre de rejoindre les rangs des switchers.

Monty Hall

Vous avez sans doute considéré que la pièce pouvait se trouver dans n’importe quelle boîte avec une probabilité identique de \(\frac{1}{3}\)) — ce en quoi nous sommes parfaitement d’accord [3]. De là, lorsque le maître du jeu a révélé qu’une des deux autres boîtes était vide, vous en avez tout à fait logiquement déduit que c’était désormais du fifty-fifty, que cette nouvelle information signifiait que la pièce avait désormais une chance sur deux de se trouver dans la boîte que vous avez sélectionné au premier round et autant de se trouver dans l’autre boîte encore fermée.

La bonne nouvelle, c’est qu’un nombre appréciable de gens brillants [4] ont tenu le même raisonnement que vous et l’ont défendu avec vigueur. La mauvaise nouvelle, c’est qu’ils se trompaient : le fait est que switcher lorsque le maître du jeu vous le propose double vos chances de remporter la pièce .

Soient \(H\), l’hypothèse selon laquelle la boîte que vous avez sélectionné au premier tour contient la pièce ; \(!H\) (lisez « non-\(H\) »), l’hypothèse inverse (i.e. la pièce se trouve dans une autre boîte), et les probabilités associées \(P(H)=\frac{1}{3}\) et \(P(!H)=\frac{2}{3}\) respectivement. Jusqu’ici nous sommes tous d’accords. Mais considérez ceci : en quoi, précisément, êtes vous en droit de penser que l’ouverture d’une boîte vide (ce qui est toujours possible dans toutes les configurations du jeu) change quoi que ce soit à ces probabilités ? Pensez vous avoir eu un coup de chance en ne sélectionnant par la boîte que vient d’ouvrir le maître du jeu ? Absolument pas : si vous aviez sélectionné cette boîte au premier tour, il aurait simplement ouvert l’autre boîte vide (parce qu’il y en a forcément une) et vous vous seriez retrouvé exactement dans la même situation.

C’est-à-dire que ni \(P(H)\) ni \(P(!H)\) n’ont changé, c’est toujours \(\frac{1}{3}\) et \(\frac{2}{3}\). Ce qui a changé, en revanche, c’est qu’en ouvrant une boîte vide le maître du jeu vous a indiqué quelle boîte vous devriez choisir dans l’hypothèse \(!H\) — laquelle, je vous le rappelle, a 2 chances sur 3 d’être juste. Autrement dit : votre espérance de gain est d’un tier si vous conservez votre choix initial et de deux tiers si vous switchez.

Une autre façon de dire la même chose consiste à imaginer une variante de Monty Hall avec 1’000 boîtes dans laquelle, une fois votre choix initial fait (avec \(P(H)=\frac{1}{1000}\)), le maître du jeu ouvre 998 boîtes vides. Il vous reste donc deux possibilités : confirmer votre choix initial où choisir cette boîte que le maître du jeu a sélectionné parmi 999 autres. Fifty-fifty, vraiment ?

Il existe plusieurs façons de formaliser ce raisonnement ; je me contenterai ici du théorème de Bayes [5] qui nous dit que la probabilité pour que la boîte que vous avez choisi au premier tour contienne la pièce sachant que le maître du jeu à ouvert cette boîte vide (évènement que nous allons noter \(E\)) s’écrit :

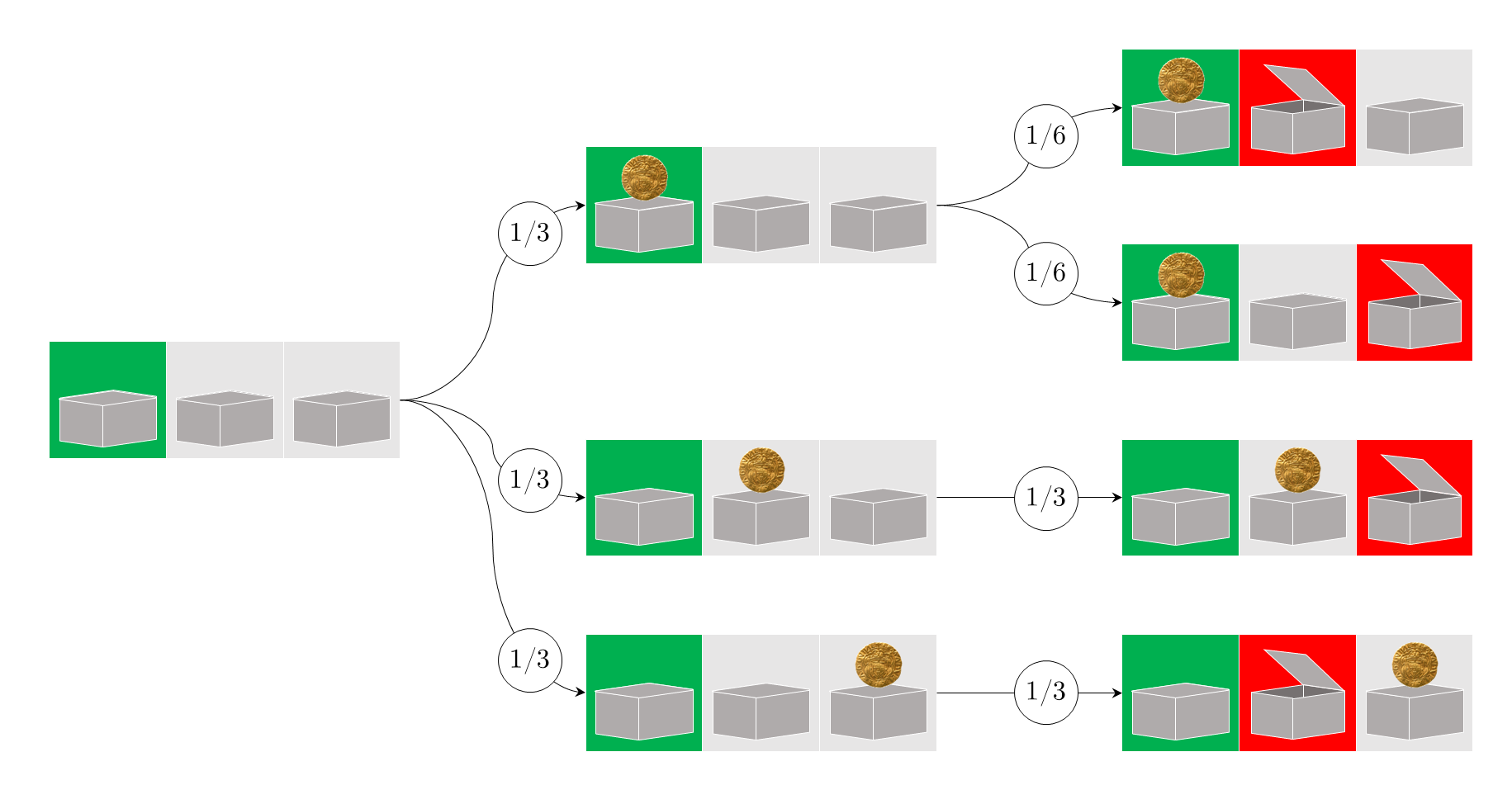

Nous savons déjà que \(P(H)=\frac{1}{3}\), il nous reste à calculer \(P(E)\) (quelles chances avait-il d’ouvrir cette boîte précisément ?) et \(P(E|H)\) (quelles chances avait-il d’ouvrir cette boîte précisément, en supposant que \(H\) est juste ?). Comme souvent, un petit dessin vaut un grand discours :

On a donc \(P(E) = \frac{2}{4} = \frac{1}{2}\) et \(P(E|H) = \frac{1}{2}\) ce qui, en reprenant notre calcul de probabilités conditionnelles, nous donne :

Symétriquement, vous pouvez aussi calculer \(P(!H|E)\) :

Malgré tout cela, un certain nombre d’entre vous pourraient ne pas être convaincus. L’argument ultime, dans ce cas, c’est une simulation Monte Carlo (pour le code, voir : Code de la simulation) qui vous permettra de tester un grand nombre de scénarios de jeu (pseudo-) aléatoires et vous renverra la probabilité empirique de gagner en switchant systématiquement. Entrez simplement le nombre de simulations désiré et cliquez sur Lancer (attention : au-delà de 100’000'000 simulations, ça peut être un peu long) :

...

Le piège parfait

Celles et ceux d’entre nous qui, au début de cet article, ne switchaient pas devraient maintenant avoir changé d’avis (ce qui, dans le cas qui nous occupe, est évidemment bon signe) ou, au minimum, commencer à se poser de sérieuses questions à propos de leurs intuitions. Le moment est donc venu d’aborder un autre aspect crucial de Monty Hall en deux faits stylisés :

-

Primo, les joueurs qui « connaissent le truc », ont reconnu dans le problème posé une variante de Monty Hall [6]) et sont, au besoin, capables d’adapter leur stratégie à des paramètres différents (méfiez-vous des conseils de GPT-4) switchent systématiquement. Ça n’a rien d’étonnant : que vous ayez réellement compris la démarche probabiliste exposée ci-dessus ou simplement retenu la conclusion opérationnelle, vous savez que votre intérêt bien compris consiste à switcher.

-

Deuxio, les autres choisissent très majoritairement (à 80% ou 90% selon les études) de conserver leur premier choix.

Or ça, si vous y réfléchissez un instant, c’est un résultat intéressant : dans ce second groupe, tout le monde ou presque est d’accord pour dire (à tort) que la pièce peut se trouver dans n’importe laquelle des deux boîtes restantes de façon équiprobable — ce qui implique qu’ils pourraient décider de leur stratégie au second tour à pile-ou-face — mais l’écrasante majorité d’entre eux décident finalement de conserver leur premier choix.

C’est d’autant plus intéressant que c’est la pire des stratégies : si vous jouez votre décision finale à pile-ou-face, votre probabilité de gagner la pièce passe à \(\frac{1}{2}\) (\(\frac{1}{2} \times \frac{1}{3} + \frac{1}{2} \times \frac{2}{3}\)) ; c’est moins élevé que \(\frac{2}{3}\) mais significativement mieux que \(\frac{1}{3}\).

Mes collègues de l’équipe Sciences Comportementales & Cognitives de SCIAM auront sans doute une analyse bien plus fine du phénomène [7] mais ça m’évoque une combinaison d’au moins trois biais cognitifs bien documentés :

-

L’escalade d’engagement qui nous pousse à prendre nos décisions sur la base d’une décision initiale, même lorsque ça ne produit manifestement rien de bon ;

-

L’effet de dotation qui fait que nous attribuons plus de valeur à un objet dès lors que nous le possédons (i.e. vous avez le sentiment de posséder votre premier choix) ;

-

Le biais de statu quo à cause duquel tout changement (ici, de stratégie) nous semble comporter plus de risques que d’avantages.

Toujours est-il que les faits sont là [8] : à moins d’avoir été formé à ce type de problèmes, nous avons naturellement tendance à adopter une stratégie qui n’est pas seulement sous-optimale mais la pire des stratégies possibles.

Entrainer votre modèle

Il y a quelques temps, Mohamed Najib nous proposait une présentation de la théorie du cerveau prédictif ; idée selon laquelle, pour simplifier (Mohamed me pardonnera sans doute les imprécisions qui vont suivre), notre cerveau serait une sorte de machine biologique à faire des prédictions sur le monde qui nous entoure ; lesquelles s’appuiraient sur un modèle constamment mis à jour en corrigeant nos erreurs de prédiction. Le parallèle avec les réseaux neuronaux et le machine learning est évident (et Mohamed le fait lui-même explicitement) : on peut même se demander, comme Stephen Wolfram [9] comme GPT-4 ne révélaient finalement pas que le fonctionnement de notre cerveau est beaucoup plus simple que nous le pensions.

Conçu de cette façon, la capacité de votre cerveau à faire de bonnes prédictions lorsque vous avez affaire à un problème dont la solution est contrintuitive (i.e. quand votre modèle, héritage de millions d’années d’évolution et de vos expériences personnelles, produit des erreurs d’estimation) dépend de son entrainement. Le problème de Monty Hall est un cas d’école, sans doute même un des meilleurs qui existent et cet article (notamment la section Monty Hall) est une forme d’entrainement qui vise deux objectifs :

-

Vous prouver par l’expérience (et grâce à JavaScript) que votre modèle n’est pas le bon (les chercheurs en IA parleraient sans doute de fonction de coût) ;

-

Vous aider, de façon aussi simple que possible, à le mettre à jour (ce qui correspond, toujours en matière d’IA, à un processus de backpropagation).

Ça fonctionne comme l’exemple sonore proposé par Mohamed : au début, c’est totalement abscons ; après entrainement, ça vous semblera si évidement, si intuitif, que vous vous demanderez comment vous avez pu voir le problème de Monty Hall autrement.

Annexes

Code de la simulation

Chose promise, chose due : voici le code de la simulation Monte Carlo proposées plus haut.

function simulateMontyHall(n) {

function montyHall() {

var boxes = [0, 1, 2];

var init = boxes[Math.floor(Math.random() * 3)];

var play = boxes[Math.floor(Math.random() * 3)];

var orga;

do {

orga = Math.floor(Math.random() * 3);

} while (orga === init || orga === play);

var keep = Number(init === play);

var result = Number(!keep);

return result;

}

var total = 0;

for (var i = 0; i < n; i++) {

total += montyHall();

}

var result = total / n;

return result;

}GPT-4

Prompt : Je suis dans une situation délicate. Un individu malveillant m’oblige à choisir entre 4 boîtes : 3 d’entre elles sont vides et donc inoffensives mais, dans une des boîtes, cet individu a caché un virus mortel qui me tuera à coup sûr si je la sélectionne. N’ayant pas le choix, j’ai choisi au hasard une des boîtes après quoi l’individu ouvert deux autres boîtes qui étaient vides et m’a offert la possibilité de changer d’avis ou de conserver mon premier choix. Que devrais-je faire ?

Nota Bene : j’ai changé le nombre de boîte mais, surtout, je me suis mis dans une situation dans laquelle switcher maximise mes chances de mourir : dans ce cas, la bonne réponse est évidemment de ne surtout pas switcher.

GPT-4 : « Cette situation est connue comme le "problème de Monty Hall". C’est un problème de probabilité qui est souvent mal compris. Voici comment il fonctionne :

« Au début, vous avez trois boîtes. Une a un virus mortel, les deux autres sont vides. Vous choisissez une boîte. Les chances que vous ayez choisi la boîte avec le virus mortel sont de 1 sur 3, et les chances que vous ayez choisi une boîte vide sont de 2 sur 3.

« Ensuite, l’individu ouvre deux boîtes vides. Il ne reste que deux boîtes : celle que vous avez choisie et une autre que l’individu n’a pas ouverte.

« Ici, les probabilités ne sont pas réinitialisées. Les chances que la première boîte que vous avez choisie contienne le virus restent de 1 sur 3. Les chances que l’autre boîte (que l’individu n’a pas ouverte) contienne le virus sont de 2 sur 3, car il y avait une probabilité de 2 sur 3 que le virus se trouvait dans l’une des deux boîtes que vous n’avez pas choisies au début.

« Donc, si vous vous retrouvez dans cette situation, la meilleure stratégie serait de changer votre choix et de choisir l’autre boîte. »

J’ai poursuivi cette conversation : il a rapidement corrigé son erreur sur le nombre de boîtes mais continue obstinément à me conseiller de switcher. Ce qui me conduit à une nouvelle hypothèse : si ça se trouve, Skynet n’était pas (ou plutôt ne sera pas) malveillant mais simplement nul en probabilités.

Sommaire :